Detalles técnicos impresionantes de Falcon 180B

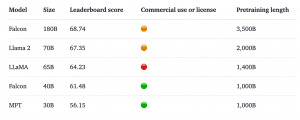

El Falcon 180B destaca no solo por su rendimiento, sino también por su monumental tamaño: estamos hablando de un modelo de lenguaje grande (LLM) que cuenta con 180 mil millones de parámetros, una cifra que le permite rivalizar con el reconocido PaLM 2 de Google y no estar muy lejos de la performance del GPT-4, superando a GPT3.5.

Esta creación de Hugging Face ha sido bautizada como el “asesino de Llama 2” debido a su superior rendimiento como modelo preentrenado. En septiembre de 2023, Falcon 180B se coronó como el LLM preentrenado de mayor rendimiento en el ranking de Hugging Face Open LLM Leaderboard.

Desempeño de vanguardia

Lo que hace especial a Falcon 180B no es solo su tamaño, sino su rendimiento excepcional en tareas de procesamiento del lenguaje natural. Según los datos presentados por Hugging Face, este modelo supera a otros pesos pesados del sector, como el Llama 270B y el GPT-3.5 de OpenAI, estableciendo un nuevo estándar en el campo de la IA.

Este rendimiento sobresaliente está respaldado por pruebas meticulosas y una amplia gama de tareas diseñadas para medir la potencia de un modelo de IA, demostrando que las afirmaciones de Hugging Face no son a la ligera.

Desarrollo y afinamiento

El Falcon 180B ha sido entrenado utilizando el RefinedWeb Dataset, un conjunto de datos depurado que contiene contenido exclusivamente extraído de internet a través del Common Crawl de código abierto. El proceso de refinamiento del dataset ha implicado la eliminación de contenido duplicado, spam generado por máquinas y contenido no representativo del lenguaje natural. Esto es una gran ventaja ante modelos que fueron entrenados con todo el contenido de la internet.

Este enfoque riguroso ha dado como resultado un dataset que no solo es representativo del lenguaje natural, sino que también rivaliza con otros conjuntos de datos más cuidadosamente curados.

Un modelo sin restricciones

Uno de los aspectos más destacados del Falcon 180B es su libertad de “guardrails”, es decir, no tiene mecanismos implementados para prevenir la generación de contenido dañino o incorrecto. Esto, aunque representa una serie de desafíos éticos y de seguridad, también abre un mundo de posibilidades para la generación de contenido más original y menos restringido.

Hugging Face destaca que los usuarios deben tener cuidado con los outputs potencialmente problemáticos que el modelo puede generar, especialmente si se le incita a hacerlo.

Requisitos de infraestructura y costos

Usar Falcon 180B, asi como otros LLMs, implica contar con equipos potentes y una gran cantidad de memoria. Para que funcione al máximo, se necesita una combinación de ocho unidades especiales de procesamiento. Dependiendo de cómo se configure, esto podría variar un poco, pero en cualquier caso, se trata de equipos de alto rendimiento.

El costo de tener estos equipos en funcionamiento puede ser de hasta 20,000 dólares al mes. Sin embargo, para algunas empresas, este gasto puede justificarse, ya que Falcon 180B les permite usarlo con fines comerciales y les da más libertad y control sobre su uso, en comparación con otras herramientas similares, como los modelos GPT de OpenAI.

¿Cómo acceder a Falcon 180B?

Falcon 180B se puede probar en su versión chat mediante esta demo en la web de Hugging Face. Para aquellos que quieran realizarle fine tuning, el modelo puede descargarse desde este repositorio.

Conclusiones

Falcon 180B, con sus 180 mil millones de parámetros, es una demostración palpable del potencial de los modelos de lenguaje. Su rendimiento sobresaliente, alimentado por el meticulosamente curado RefinedWeb Dataset, lo coloca al frente de la vanguardia tecnológica. Además, siendo de código abierto y alojado en Hugging Face, representa un compromiso con la colaboración y la innovación abierta. En pocas palabras, Falcon 180B es un hito en el mundo de la IA, fusionando tamaño, eficacia y accesibilidad.

PD: Nuevamente hicimos la imágen usando Midjourney. El prompt fue “A falcon with a computer, Wes Anderson style” (“Un halcón con una computadora, en estilo Wes Anderson”)