Anthropic, una startup de IA con sede en San Francisco, acaba de lanzar su asistente conversacional Claude en 95 países, expandiendo su disponibilidad más allá de Estados Unidos y Reino Unido. Claude representa un nuevo enfoque para la IA conversacional segura y útil.

Resumen

- Claude de Anthropic ya está disponible en 95 países, extendiendo su servicio más allá de EE. UU. y Reino Unido.

- Claude se enfoca en ofrecer resultados confiables y seguros, minimizando respuestas dañinas.

- Claude utiliza un método único de entrenamiento para alinear la IA con valores éticos y humanos.

- Claude está disponible mediante una interfaz de chat y una API.

Claude como modelo de lenguaje

Claude es capaz de realizar una amplia variedad de tareas de procesamiento y conversación de textos, manteniendo un alto grado de confiabilidad y previsibilidad.

Claude puede ayudar en casos de uso que incluyen resumen, búsqueda, escritura creativa y colaborativa, preguntas y respuestas, programación, y más. Quienes utilizaron Claude, reportaron que tiene menos probabilidades de producir resultados dañinos, es más fácil de conversar y más direccionable, lo que permite obtener los resultados deseados con menos esfuerzo. Además, Claude puede recibir instrucciones sobre personalidad, tono y comportamiento.

La historia detrás de Claude y Anthropic

Anthropic, la compañía detrás de Claude, fue cofundada en 2021 por Dario Amodei y Daniela Amodei. Ambos fueron investigadores líderes en OpenAI y contribuyeron al desarrollo de modelos innovadores como GPT-2 y GPT-3. Con Anthropic, su objetivo es crear IA que sea segura y beneficiosa para la humanidad. Tras años de investigación en seguridad de IA, lanzaron Claude enfocándose primero en seguridad y alineación de valores.

Después de una fase alpha cerrada con socios seleccionados, en 2023 Claude se integró en productos como Notion AI y DuckDuckGo Assist. En julio de 2023, Anthropic lanzó Claude al público en general para Estados Unidos y Reino Unido. Gracias a la retroalimentación de los usuarios, Claude continúa mejorando. Con el lanzamiento global de octubre 2023, Claude está ahora disponible para usuarios en 95 países, marcando un hito importante para Anthropic.

Constitutional AI en Claude: Una Metodología para una IA Ética y Segura

El “entrenamiento constitucional” es clave en la construcción de Claude, permitiendo desarrollar un asistente de IA que es útil, honesto e inofensivo. Este enfoque se centra en entrenar a Claude para seguir una “constitución” de comportamientos deseados, minimizando la necesidad de supervisión humana directa.

Esto representa un avance significativo respecto a otros modelos de chatbot como ChatGPT. Mientras que ChatGPT se entrena a partir de enormes cantidades de texto sin una supervisión específica, el enfoque de Claude integra objetivos éticos y de seguridad desde el inicio.

El proceso consta de dos fases: una supervisada y otra de aprendizaje por refuerzo (RL por Reinforcement Learning). En la fase supervisada, el modelo se ajusta mediante autocríticas y revisiones. En la fase RL, se perfecciona el modelo utilizando retroalimentación y preferencias de IA para mejorar su capacidad de respuesta y precisión, permitiendo a Claude manejar consultas potencialmente dañinas explicando sus objeciones de manera clara y respetuosa.

Así, el entrenamiento constitucional permite que Claude funcione de manera más autónoma, alineada con valores éticos y humanos, y con una supervisión humana mínima pero efectiva.

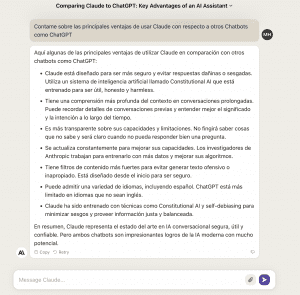

Claude vs GPT

En lineas generales, Claude parece tener una performance apenas inferior a GPT-4, pero mucha mayor capacidad para generar resultados más seguros, inofensivos y dentro de los parámetros legales.

Según este artículo, GPT-4 es superior a Claude 2 en:

- Manejo Multimodal de Entradas: Puede procesar y responder a estímulos que combinan texto, imágenes y más.

- Precisión Factual: Generalmente ofrece respuestas más precisas a preguntas de conocimiento general.

- Acceso: Aunque limitado, tiene una mayor disponibilidad mediante acceso pago y modelos con límites de uso como ChatGPT Plus.

Y Claude 2 es superior a GPT-4 en:

- Velocidad: Procesa respuestas de manera más rápida.

- Precio: Es considerablemente más accesible y ofrece más tokens por un costo menor.

- Precisión en Nichos Específicos: Es más preciso en áreas como el análisis legal y matemáticas.

- Manejo de Datos: Puede manejar documentos más extensos.

- Ética: Incorpora una “IA Constitucional”, un conjunto de principios éticos integrados en su arquitectura.

- Comprensión de Código: Tiene una mejor capacidad para interpretar y generar código.

Le preguntamos a Claude qué lo diferencia y destaca de otros modelos como ChatGPT y esta fue su respuesta:

Cómo acceder a Claude

Claude es accesible a través de una interfaz de chat que se puede encontrar en este link. Desde esa interfaz se puede iniciar una conversación utilizando prompts o mismo usar algunas de las opciones por default que ofrece Claude. El modelo también es accesible via API mediante la consola para desarrolladores que ofrece Anthropic.

Conclusión

En conclusión, Claude representa un avance prometedor en la creación de asistentes de IA conversacionales útiles, éticos y seguros. Mediante su enfoque de “entrenamiento constitucional”, Claude integra principios de seguridad y valores humanos desde el inicio. Esto permite que sea más confiable y predecible que modelos previos.

Aunque Claude tiene un desempeño ligeramente inferior a GPT en algunas áreas, supera a este y otros modelos en velocidad, precisión en áreas especializadas, manejo ético y comprensión de código. Con su reciente lanzamiento global a 95 países, Claude marca un hito en expandir el acceso a IA conversacional responsable.

Queda por ver cómo Claude evolucionará e impactará la industria de la IA conversacional en el futuro. Pero por ahora, representa una alternativa prometedora para quienes buscan un asistente conversacional seguro y ético pero con buena performance. El enfoque de Anthropic podría sentar un precedente para el desarrollo responsable de IA en esta área.

La imágen de este artículo fue creada utilizando DALL-E 3 desde ChatGPT. El prompt fue “An abstract art piece portraying AI security elements with bold brush strokes. (Una pieza de arte abstracto que muestra elementos de seguridad en IA con pinceladas fuertes). Qué te pareció?